Aufzeichnung Webinar

Bridging Business and Analytics: The Plug-and-Play Future of Data Platforms

(Aufzeichnung in englischer Sprache)

Shaping Business Intelligence

Über uns

Unsere Methodik

Data Science & Engineering

SAP Planning

Business Intelligence

Databricks ist das marktführende Data-Lakehouse-Produkt und Vorreiter für universell einsetzbare cloudbasierte Datenverarbeitungs- und Analyseplattformen. Es bietet eine zentrale Anlaufstelle für eine Vielzahl von Akteuren aus datengesteuerten Unternehmen: von Domain-Experten und Analysten bis hin zu Dateningenieuren und Datenwissenschaftlern. Führen Sie alle Unternehmensdaten in einem zentral verwalteten, skalierbaren Speicher zusammen und verwandeln Sie sie in nutzbare Datenbestände für Reporting, Planung und Prognosen.

Databricks ist Pionier und Namensgeber im Data Lakehouse Bereich. Diese Architektur trennt Speicher- und Rechenressourcen, sodass beide unabhängig voneinander skalierbar sind. Die Kommunikation zwischen Speicher- und Computing-Schichten verwendet Protokolle und Konzepte, die Parallelisierung und horizontale Skalierung nativ unterstützen. Auf diese Weise lassen sich deutlich größere Datenmengen speichern und verarbeiten als in herkömmlichen Datenbanksystemen.

Unsere-Experten haben Databricks als die umfassendste und benutzerfreundlichste Cloud-basierte Daten- und Analyseplattform am Markt ausgewählt. Unsere Kunden nutzen die hocheffizienten Datenverarbeitungs- und Integrationsfunktionen, um Einblicke zu gewinnen, Wettbewerbsvorteile zu sichern und aus Daten messbaren Wert zu schöpfen.

Databricks vereint Data Science und Business Intelligence in einer zentralen Plattform. Der Umfang der Funktionalitäten lässt sich kaum in wenigen Sätzen erfassen. Die folgenden fünf Fakten, zeigen auf, wie Databricks Ihr Unternehmen unterstützt, Daten in messbaren Erfolg umzuwandeln:

![]()

![]()

![]()

![]()

![]()

Databricks ist die funktionsreichste und innovativste Cloud-Datenplattform auf dem Markt. Mit dem Aufkommen der Data-Lakehouse-Architektur konvergiert die klassische Data-Warehouse-Technologie in Richtung ähnlicher Skalierbarkeit und Funktionen. In den vergangenen Jahren haben Plattformen zunehmend Tools für spezifische Aspekte der Daten-, Analyse- und KI-Landschaft integriert. Heute haben mehrere Anbieter Komplettlösungen für nahezu jedes mögliche Szenario im Angebot, mit dem Unternehmen im Umgang mit Daten konfrontiert werden könnte:

Darüber hinaus erobern Dremio und MotherDuck ihre Nischen auf dem aufstrebenden Lakehouse-Markt.

Bei diesen vielfältigen Angeboten ist es kaum möglich, den Funktionsumfang und die Reife all dieser potenziellen Alternativen gegeneinander abzuwägen.

Wir haben einen übersichtlichen Quervergleich zwischen vier Hauptakteuren in einer Matrix für Sie zusammengestellt:

|

|

Business Data Cloud

|

Microsoft Fabric

|

|

|

|

Betriebsmodell |

Cloud Platform-as-a-Service |

Cloud Platform-as-a-Service |

Cloud Platform-as-a-Service |

Public/Private Cloud Software-as-a-Service (Dremio oder beliebiger Cloud-Provider) |

|

Funktionsumfang |

Data Lakehouse, |

Data Warehouse, |

Data Warehouse, Data Lakehouse, |

Data Lakehouse, Self-Service Analytics (SQL) |

|

Stärken |

Offene Schnittstellen und Konnektivität, Kosteneffizienz |

Enterprise Software Integration (SAP) |

Enterprise Software Integration (Microsoft) |

Offene Schnittstellen und Konnektivität, Kosteneffizienz |

|

Fazit |

All-in-one Plattform mit pro-code / low-code Fokus |

All-in-one Plattform mit low-code / no-code Fokus |

All-in-one Plattform mit low-code / no-code Fokus |

Lakehouse-Spezialsystem mit pro-code / low-code Fokus |

Databricks vereint modernste Komponenten und Funktionen für Data Warehousing und Data Engineering in einer Plattform. Ob große Datenmengen, hohe Geschwindigkeit, komplexe Muster oder sich ständig ändernde Quellschemata – Databricks bietet die passenden Tools, um Daten effizient zu erfassen und zu harmonisieren. Semantisch reichhaltige, normalisierte Datenmodelle lassen sich mühelos auf Basis von Delta-Lake-Tabellen erstellen. . Noch nie war es so einfach, zentrale und vertrauenswürdige Datenquelle für alle Analysezwecke aufzubauen - und das auf nur einer Plattform.

Databricks unterstützt Sie dabei, relevante Daten wie historische Batch-Daten aus Altsystemen oder Echtzeit-Streaming Daten aus verschiedenen Quellen in eine einheitliche Umgebung zu integrieren.

Anstelle von fragmentierten Datenpipelines mit verschiedenen Tools bietet Databricks eine zentrale Plattform für die Datenerfassung, -verarbeitung und -verwaltung. Dies ermöglicht eine zuverlässige Grundlage für Analyse-, Reporting- und maschinelle Lernprojekte - über Teams und Anwendungfälle hinweg.

Zu den zentralen Funktionen gehören:

‣ Autoloader

Änderungen an einem Objektspeicher oder einer Dateisystemquelle überwachen sowie geänderte oder neue Dateien automatisch in Echtzeit verarbeiten.

‣ Lakeflow ETL

Intuitive Benutzeroberfläche zum Erstellen von Pipelines zum Datenimport aus verschiedenen Quellsystemen.

‣ Lakehouse Connect

Integration bestehender Datenbanken als Plug-in inkl. direkter Abfrage - als wären sie ein weiterer Namespace im Databricks Unity Catalog.

‣ Spark-JDBC

Native Apache Spark-Job-Parallelisierung, um Daten mit maximalem Durchsatz zu und von jedem entfernten JDBC-kompatiblen System zu übertragen.

Databricks nutzt Apache Spark zur Verarbeitung großer Datenmengen und anspruchsvoller Arbeitslasten. Die Plattform skaliert Ressourcen automatisch - je nach Umfang der Tasks. Dank dieses verbrauchsorientierten Preismodells zahlen Sie nur für die tatsächlich genutzten Berechnungen. Dank dieser Flexibilität können Teams umfangreiche Datensätze verarbeiten, komplexe Transformationen sowie erweiterte Analysen durchführen, ohne sich Gedanken um Kapazitätsengpässe oder unerwartete Kosten machen zu müssen.

Mit Databricks arbeiten Entwickler und Datenwissenschaftler in gemeinsamen Arbeitsbereichen effektiv zusammen. Die Plattform unterstützt mehrere Programmiersprachen – u. a. Python, SQL und R – und wird damit zur idealen Umgebung für die Entwicklung und Pflege von Datenpipelines. Darüber hinaus erleichtert die integrierte Git-Integration die Versionskontrolle, fördert strenge Dokumentationspraktiken und ermöglicht es Teams, auf transparente Weise zusammenzuarbeiten und den Entwicklungsfortschritt zu verfolgen. Lösungen können direkt über Jupyter Notebooks auf der Plattform entwickelt, getestet und bereitgestellt werden - so können Entwicklungsteams nahtlos vom Prototyping zur Produktion übergehen, ohne zwischen unterschiedlichen Tools wechseln zu müssen.

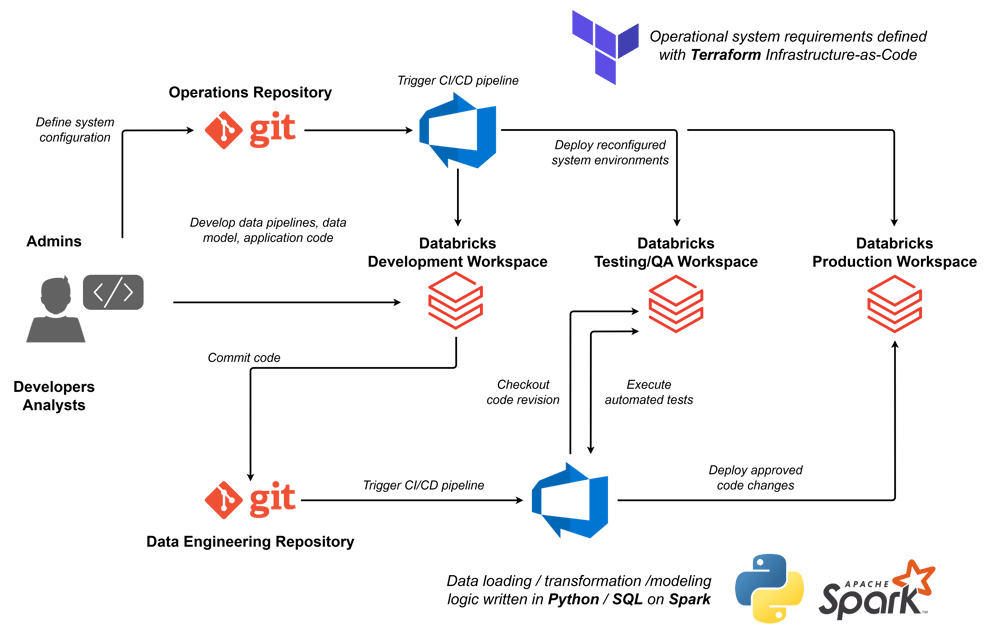

Databricks DevOps-Prozesse am Beispiel von Azure DevOps: Über den drei Databricks-Systemumgebungen ist der Infrastructure-as-Code-Prozess dargestellt, der Systemkomponenten wie Workspaces und Berechtigungsverwaltung, Spark-Cluster, Databricks-Jobs usw. mit Terraform definiert, überprüft und bereitstellt. Der Entwicklungsprozess für die Datenverarbeitung im Lakehouse ist in der unteren Hälfte dargestellt. SQL- und Python-Notebooks sowie zentrale Python-Bibliotheken werden im Dev-Workspace von Databricks entwickelt, versioniert und mit Git synchronisiert, automatisch getestet und über die Pipeline bereitgestellt.

Mit Databricks erstellen Sie ein vollständig virtuelles Echtzeit-Datenmodell über Ihren logischen Layer hinweg - basierend auf Delta Live Tables. Folgen Sie gängigen Datenarchitekturmustern wie Data Vault oder Medallion und nutzen Sie branchenübliche Tools wie dbt für die kollaborative Modellierung, um das gewünschte Ergebnis zu definieren - statt sich mit der technischen Logik der Massenverarbeitung zu beschäftigen. Sobald das zentral verwaltete Datenmodell in Unity Catalog eingerichtet ist, können Leistung und Änderungsverlauf in der gesamten Landschaft mit integrierten Funktionen für den Delta-Tabellenverlauf und die Datenherkunft verfolgt werden. KI-gestützte,verständlich formulierte Anmerkungen im Unity Catalog machen es Fachanwendern leichter, sich im Datenmodell zurechtzufinden und über Self-Service SQL-Abfrageoberflächen und BI-Dashboards Einblicke zu gewinnen.

Databricks ist eine ausgereifte, sich ständig weiterentwickelnde Entwicklungsplattform für Machine Learning, Deep Learning, generative KI, Retrieval Augmented Generation, agentische KI-Systeme sowie weitere Varianten aktueller datenwissenschaftlicher Trends. Wie kein anderes Softwareprodukt kombiniert Databricks KI und BI zu einem echten Data-Intelligence-Arbeitsbereich - für schnelle Erkenntnisse und Wettbewerbsvorteile.

Mit den integrierten Dashboards von Databricks lassen sich wichtige Leistungskennzahlen in Echtzeit überwachen - ganz ohne zusätzliche Software oder aufwendige Einrichtung. Dank verschiedener Visualisierungsoptionen können Datenteams schnell verständliche Berichte erstellen. So erkennen Sie schneller Trends, können Erkenntnisse direkt teilen und fundierte Entscheidungen für Ihr Unternehmen treffen.

Die Entwicklung,Feinabstimmung, Bewertung und Bereitstellung von Machine-Learning-Modellen wird unter dem Begriff MLOps zusammengefasst. Die ML-Plattform von Databricks unterstützt Sie, Modelle für maschinelles Lernen entlang dieses Prozesses in einer integrierten Umgebung zu trainieren, einzusetzen und zu verwalten. Dabei arbeiten Sie in einer integrierten Umgebung, die direkt auf Ihre Daten zugreift und diese verarbeitet. Durch diese enge Verknüpfung von Daten und Modellierung gewinnen Sie Erkenntnisse basierend auf den aktuellsten Informationen. So lassen sich durch intelligente Automatisierung und prädiktive Analysen neue Möglichkeiten erschließen und Arbeitsabläufe optimieren.

Statt mehrere Softwarelösungen zu kombinieren, um einen durchgängigen MLOps-Prozess abzubilden, stellt Databricks Ihren Data Scientists alle notwendigen Bausteine zur Verfügung:

‣ Datenzugriff und Feature-Engineering

Integrieren Sie alle Ihre Quelldaten im Unity Catalog und nutzen Sie Jupyter Notebooks oder Spark SQL, um Rohdaten in optimierte Features für Ihr ML-Modell umzuwandeln.

‣ Feature Store

Vollständig definierte Features werden im Delta Lake-Format im Unity Catalog gespeichert und als dedizierte Feature-Tabellen für den Einsatz in ML-Modellen bereitgestellt.

‣ Training von Modellen

Für die Entwicklung und das Training neuer ML-Modelle, können Sie die Rechenleistung von Apache Spark, beliebige Python-Bibliotheken von Drittanbietern und Machine-Learning-Frameworks wie TensorFlow, XGBoost, Keras oder Scikit-Learn nutzen. Mit der vollständig integrierten mlflow-Umgebung behalten Sie dabei den Überblick über Versionen, Experimente und Performance.

‣ Modellverfolgung und -bewertung

Modellversionen werden direkt im Unity Catalog gespeichert und mlflow verfolgt den vollständigen Versuchs- und Leistungsverlauf zur Bewertung.

‣Modellbereitstellung

Produktionsreife Modelle lassen sich direkt aus dem Unity Catalog unter dem zentralen Governance-Schema mit mlflow per REST-API bereitgestellen. Alternativ können sie in Spark SQL für Ad-hoc-Inferenzen in Analyseabfragen integriert oder mit dem Databricks Apps-Framework in vollständig benutzerorientierte grafische Anwendungen umgewandelt werden.

Databricks treibt Innovation durch den Einsatz agentischer und generativer KI voran und ermöglicht Zugriff auf LLM-Basismodelle sowie KI-Integration in SQL-Abfragen. Das Mosaic AI Agent Framework ist ein umfassendes Toolkit, welches die Entwicklung, Bereitstellung und Evaluierung produktionsreifer KI-Agenten, wie z. B. RAG-Anwendungen (Retrieval Augmented Generation) vereinfacht. Dieses Framework unterstützt die Integration externer Tools wie LangChain und LlamaIndex, sodass Entwickler bevorzugte Frameworks verwenden und gleichzeitig den verwalteten Unity-Catalog sowie das Agentenbewertungs-Framework von Databricks nutzen können.

Das Mosaic AI Agent Framework bietet eine Vielzahl an Funktionen zur Optimierung der Agentenentwicklung. Entwickler können KI-Agenten erstellen und anpassen, eigene Agenten-Tools zur Erweiterung der LLM-Funktionen erstellen, Agenteninteraktionen zur Fehlerbehebung nachverfolgen und die Agenten hinsichtlich Qualität, Kosten und Latenz bewerten. Darüber hinaus unterstützt das Framework die Qualitätsverbesserung der Agenten mithilfe von DSPy, die Automatisierung der Prompt-Entwicklung und die Feinabstimmung. Schließlich können Agenten mit Funktionen wie Token-Streaming, Request/Response-Protokollierung und einer integrierten Überprüfungs-App für Benutzerfeedback in der Produktion eingesetzt werden.

Mit dem Databricks-Assistenten stellt Databricks ein leistungsstarkes KI-Tool zur Verfügung, das die Leistungsfähigkeit großer Sprachmodelle nutzt, um Benutzer auf vielfältige Weise mithilfe generativer KI zu unterstützen. Dies kann durch Abfragen von Daten in natürlicher Sprache, durch Generierung von SQL- oder Python-Codes, durch Erklärung komplexer Code-Segmente oder gezielter Hilfe bei der Fehlersuche erfolgen.

Der Assistent basiert auf der DatabricksIQ Intelligence Engine und ist tief in die Databricks-Plattform integriert. Er kann personalisierte kontextbezogene Antworten zu Daten, Code und Teilen Ihrer Konfiguration liefern. DatabricksIQ integriert Informationen aus dem Unity-Catalog, Ihren Dashboards, Notizbüchern, Datenpipelines und Dokumentationen, und generiert Antworten, die auf Ihre Geschäftsprozesse und Arbeitsabläufe abgestimmt sind.

Databricks unterstützt eine sichere und effiziente Zusammenarbeit in der Cloud mit integrierten Sicherheits-, Compliance- und Kollaborationswerkzeugen. So können Dateningenieure, Geschäftsanalysten und Domain-Experten gemeinsam an datengetriebenen Lösungen arbeiten.

![]()

Die Lakehouse-Architektur von Databricks kombiniert die Funktionalitäten von Data Lakes und Data Warehouses in einer Plattform. Dies reduziert die Gesamtbetriebskosten, verringert die Komplexität und richtet Datenstrategien auf Geschäftsziele aus.

![]()

Die SAP Business Data Cloud vereint mehrere bisher getrennte Produkte in einer leistungsfähigen Cloud-Plattform für Datenmanagement und Business Intelligence:

Anfang 2025 wird ein vollständig integrierter Databricks-Arbeitsbereich Teil der SAP Business Data Cloud.

Einige der Kernkomponenten von Databricks wurden in die SAP Business Data Cloud-Produktsuite integriert:

Ferner enthalten sind Kernfunktionen von Databricks wie:

SAP-Datenmodelle sind nahtlos im Databricks-Katalog verfügbar - und umgekehrt. Dies verspricht eine effiziente, kopierfreie Datenintegration zwischen etablierten SAP-Geschäftsdomänendaten und Drittanbietersystemen - oder sogar unstrukturierten Daten.

Technologisch basiert diese Integration auf den nativen Data-Lakehouse-Innovationen von Databricks wie dem Delta-Lake-Tabellenformat und dem Delta-Sharing-Austauschprotokoll.

Für Unternehmen, die in großem Umfang auf SAP setzen und schon in die Cloud native Datasphere-Umgebung investiert haben, stellt “SAP Databricks“ eine komfortable Lösung dar. Sie bietet eine integrierte Alternative zu einer eigenständigen Databricks-Lösung.

Sie möchten mehr über Szenarien zur Integration von SAP und Databricks erfahren oder fragen sich, ob entweder die Business Data Cloud oder die klassische Databricks-Lösung die richtige Wahl für Sie ist?

Wir beraten Sie gerne zu Ihren Integrationsszenarien mit SAP und Databricks.

Mit SAP Databricks, das inzwischen fest in die SAP Business Data Cloud integriert ist, gehen viele...

Ein Jahr ist vergangen, seit SAP im Februar 2025 die neue Produktstrategie für ihre Datenplattform...

Die heutige Datenwelt ist ein sich rasant entwickelndes Feld, in dem Unternehmen zunehmend auf...

Aufgrund der besseren Lesbarkeit wird im Text das generische Maskulinum verwendet. Gemeint sind jedoch immer alle Menschen.

Aufgrund der besseren Lesbarkeit wird im Text das generische Maskulinum verwendet. Gemeint sind jedoch immer alle Menschen.