Unternehmen, die ihre Entscheidungen auf Daten und belastbare Erkenntnisse stützen, sichern sich einen entscheidenden Wettbewerbsvorteil und erschließen großes Potenzial für effizientere und optimierte Prozesse. Um diese Vorteile zu realisieren, müssen zunächst die richtigen Daten gesammelt und anschließend in geeignete Analysemodelle eingespeist werden – beispielsweise zur Prognose von Umsatz oder Absatz für zukünftige Zeiträume.

Business-Intelligence-Lösungen wie Power BI oder SAP Analytics Cloud unterstützen zwar einfache Prognoseverfahren und Planungsaufgaben, stoßen jedoch schnell an ihre Grenzen, sobald die Anforderungen komplexer werden.

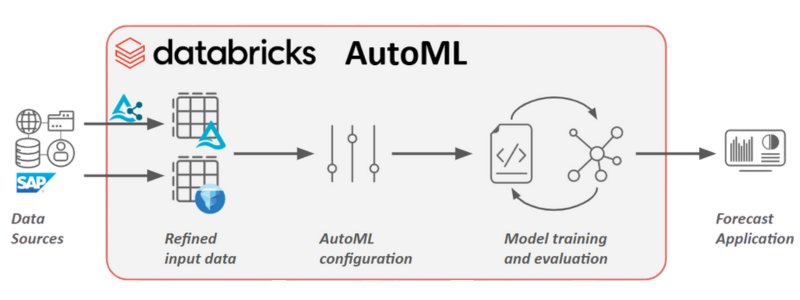

Databricks ist eine umfassende Plattform für Machine Learning, Data Science und KI-Entwicklung, die sich hervorragend für die Erstellung innovativer und präziser Prognoseanwendungen eignet. Zwischen einfachen Planungsfunktionen und hochkomplexen, individuell entwickelten ML-Modellen liegt ein breites Feld für Predictive Analytics mit mittlerem Schwierigkeitsgrad – und genau hier setzt AutoML an. AutoML ermöglicht präzise Vorhersagen, ohne dass tiefgehende mathematische Expertise erforderlich ist.

Im Folgenden zeigen wir, wie sich Databricks AutoML für Zeitreihenprognosen nutzen lässt – und wie sich damit Geschäftsdaten mit minimalem Programmieraufwand in handlungsrelevante Erkenntnisse verwandeln.

Finden Sie hier unsere Blogserie „Hands-on Databricks“: |

| 1. So nutzen Sie SAP Databricks zur Integration von ServiceNow-Daten |

| 2. Datenmodellierung mit dbt auf Databricks: Ein Praxisleitfaden |

| 3. Databricks AutoML für Zeitreihen: Schnelle und zuverlässige Absatzprognosen |

| 4. Effizientes Data Warehousing in Databricks mit dbt Makros & Snapshots |

Databricks AutoML

Databricks vereint Data Engineering, Analytics und Machine Learning auf der Lakehouse-Plattform – einer integrierten Umgebung, die skalierbare Rechenleistung, zuverlässige Datenspeicherung und kontrollierte Zusammenarbeit zusammenführt.

In einem früheren Beitrag zu Databricks & MLflow haben wir bereits gezeigt, wie sich Experimente nachverfolgen, Modelle versionieren und Deployments vereinfachen lassen. Darauf bauen wir nun auf:

Ausgehend von einem einfachen Verkaufsdatensatz visualisieren wir zunächst Trends und Saisonalität, bevor Databricks AutoML potenzielle Prognosemodelle automatisch erkundet. AutoML trainiert und optimiert Modelle im großen Stil, generiert dabei nachvollziehbare Notebooks und registriert die Ergebnisse in MLflow. So lassen sich Modelle reproduzieren, anpassen und problemlos in den produktiven Betrieb überführen.

Wichtige AutoML-Funktionen im Überblick

- Automatisierte Zeitreihen-Feature-Erstellung

Automatisch generierte Lags, gleitende Durchschnitte, Feiertags- und Kalendermerkmale erfassen Trends und Saisonalitäten – ganz ohne manuelle Feature-Engineering-Aufwände. - Modellfindung und -optimierung „out of the box“

AutoML testet Modelle wie Prophet, ARIMA/SARIMA, Gradient Boosted Regressors oder Deep-Learning-Ansätze (sofern verfügbar) und optimiert deren Hyperparameter skalierbar. - Transparente, lesbare Notebooks

Automatisch erstellte Notebooks zeigen alle Schritte – von der Datenvorbereitung über Feature-Erstellung bis hin zu Training und Evaluierung – und können jederzeit überprüft, angepasst oder erneut ausgeführt werden. - Robuste Evaluierung und Backtesting

Rolling-Window-Validierung, Prognoseplots, Fehlermetriken (z. B. MAPE, RMSE) sowie Baseline-Vergleiche sorgen dafür, dass die Modelle signifikante Verbesserungen gegenüber einfachen Prognosen liefern. - Ein-Klick-Operationalisierung

Nahtloses MLflow-Tracking, Modellregistrierung mit Versionierung und einfache Bereitstellung für Batch-Scoring oder Echtzeit-Model-Serving.

Databricks & AutoML: Ein End-to-End Beispiel

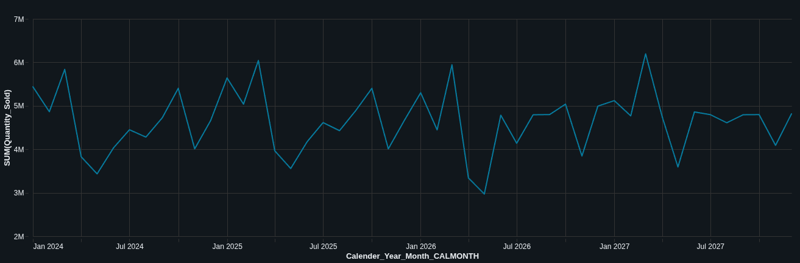

Unser Ziel: die monatlichen Gesamtumsätze eines Einzelhandelsunternehmens zu prognostizieren. Zunächst visualisieren wir die Verkaufsdaten - um Muster, Trends und saisonale Effekte zu erkennen.

Es zeigt sich ein deutliches Muster: Die Umsätze erreichen im März ihren Höhepunkt, sinken danach deutlich ab und erholen sich im weiteren Jahresverlauf langsam wieder.

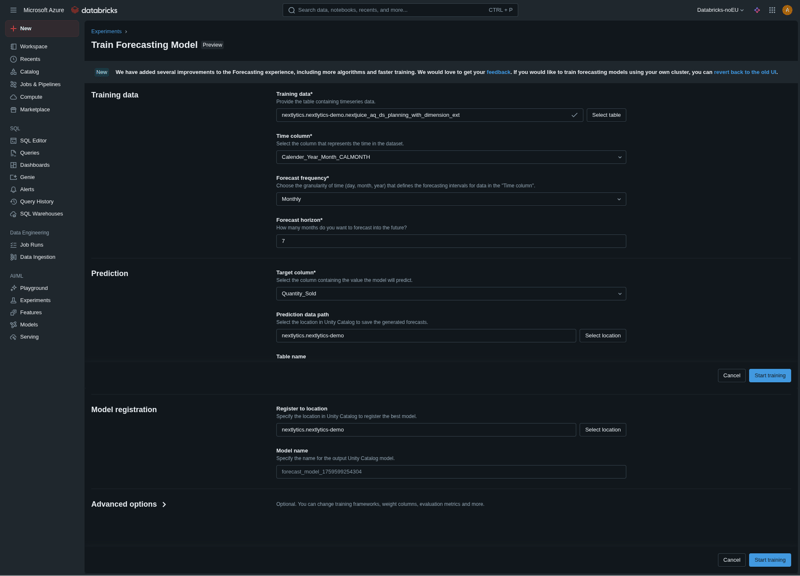

Auf dieser Basis starten wir das Training und die Optimierung der Prognosemodelle. Dabei definieren wir Parameter wie Zeit- und Zielspalte, Prognosehorizont sowie Speicherorte für Modellregistrierung und Vorhersagen.

Sehen Sie sich die Aufzeichnung unseres Webinars an: "Bridging Business and Analytics: The Plug-and-Play Future of Data Platforms"

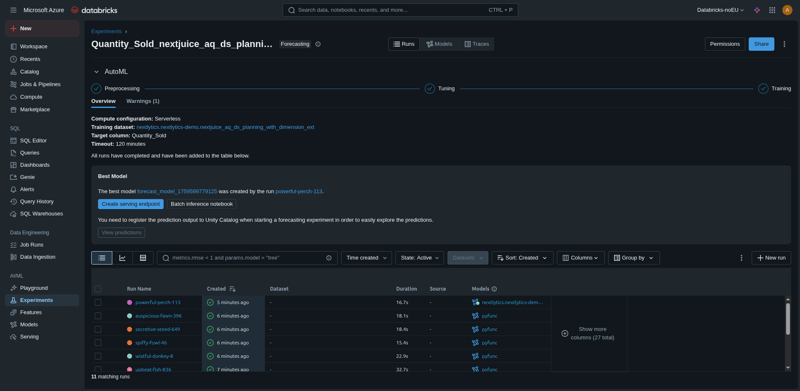

Anschließend startet das Experiment – AutoML übernimmt die gesamte Vorverarbeitung, Modelloptimierung und das Training vollständig automatisiert. Bereits nach wenigen Minuten stehen die Ergebnisse zur Verfügung, und das beste Modell wird im Unity Catalog gespeichert – bereit für den produktiven Einsatz.

Databricks AutoML testet und bewertet verschiedene Zeitreihenmodelle anhand von Kennzahlen wie MAPE (Mean Absolute Percentage Error), RMSE (Root Mean Square Error) und weiteren Metriken.

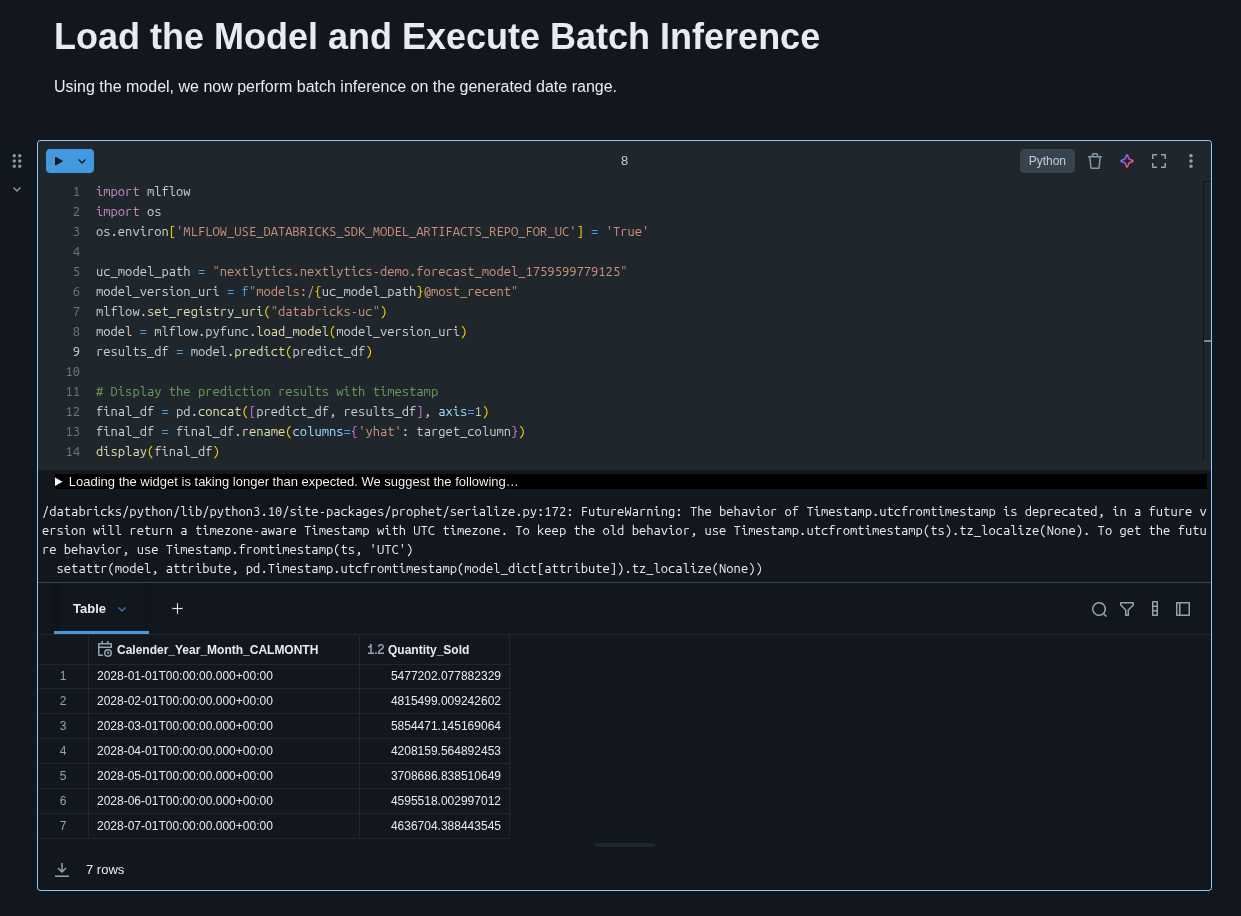

Ein automatisch erzeugtes Python-Notebook ermöglicht anschließend die Ausführung und Erstellung von Prognosen für zukünftige Zeiträume.

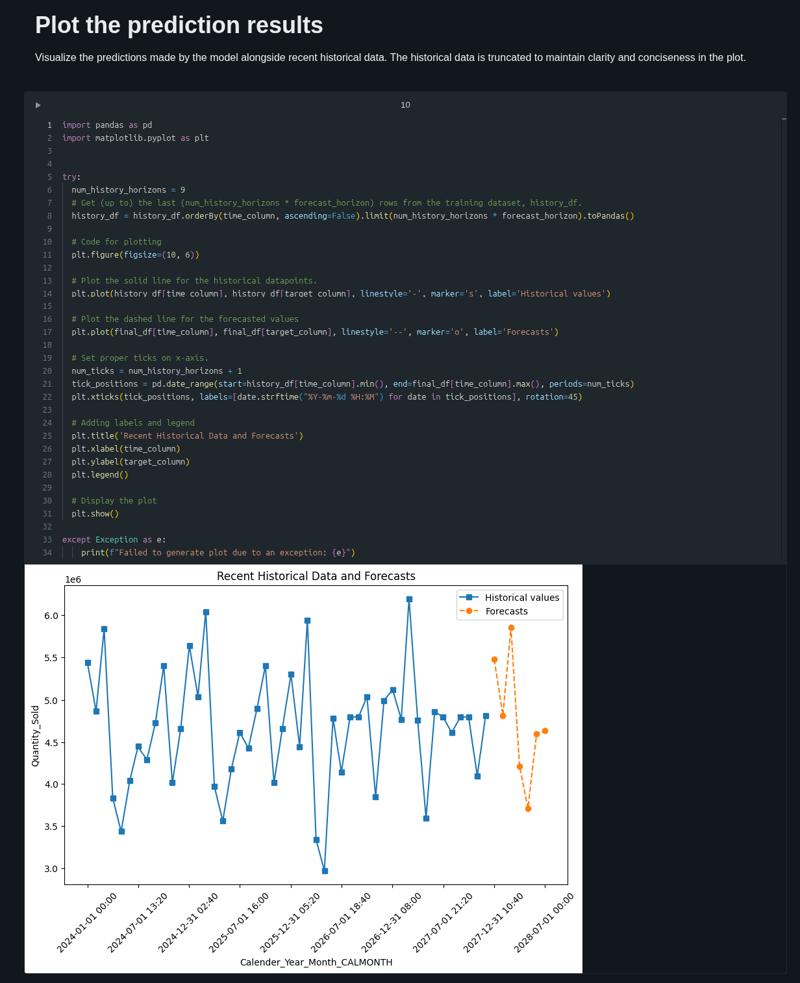

Das optimale Modell wird geladen, und Vorhersagen für die kommenden sieben Monate werden generiert. Die durch AutoML erstellte Visualisierung zeigt, dass die Prognose die tatsächlichen Werte sehr genau abbildet und die historischen Trends präzise fortschreibt.

Die Absatzprognose sagt einen deutlichen Frühjahrs Aufschwung voraus, gefolgt von einem kurzfristigen Rückgang und einer moderaten Erholung – ein Beleg dafür, dass das Modell zyklische und temporäre Marktdynamiken zuverlässig erfasst und somit wertvolle Erkenntnisse für die Geschäftsplanung liefert.

AutoML in der SAP Business Data Cloud

SAP-Systeme sind weit verbreitet und zählen zu den wichtigsten Quellen für betriebswirtschaftliche und operative Daten. Zwar lassen sich erweiterte Analysen auch außerhalb des SAP-Ökosystems durchführen, doch ist dies oft mit zusätzlichem Aufwand durch Drittanbieter-Tools oder individuelle Schnittstellen verbunden.

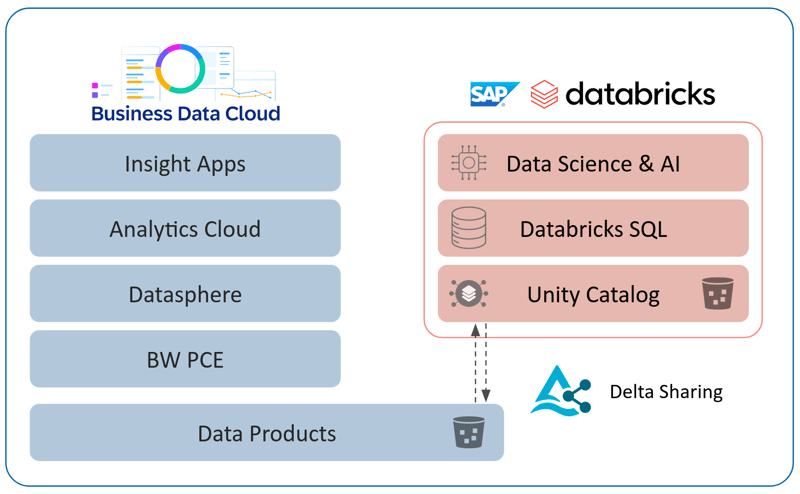

Mit der SAP Business Data Cloud steht nun eine integrierte Lösung zur Verfügung: Sie verbindet die SAP Datasphere direkt mit dem Databricks-Workspace – beispielsweise für die oben gezeigten AutoML-Zeitreihenprognosen.

Datenprodukte können dabei ohne Replikation zwischen SAP Datasphere und Databricks ausgetauscht werden. Databricks führt die AutoML-Experimente oder individuelle Machine-Learning-Workflows aus, während die Ergebnisse nahtlos zurück in das SAP-Analytik-Ökosystem oder externe BI-Tools wie Microsoft Fabric oder Power BI übertragen werden können.

Da SAP-Systeme stark auf Low-Code/No-Code-Oberflächen setzen, ist der Funktionsumfang zwar benutzerfreundlich, jedoch begrenzt. Mit den in Databricks AutoML verfügbaren Features lässt sich diese Lücke schließen:

SAP Databricks vereint die einfache Bedienbarkeit der SAP-Welt mit der Flexibilität einer professionellen Entwicklungsumgebung und fördert so datengetriebene Innovation direkt auf Grundlage verlässlicher Geschäftsdaten aus den operativen Quellsystemen.

Databricks AutoML: Unser Fazit

Databricks AutoML macht Zeitreihenprognosen praxisnah, transparent und produktionsreif – in einem durchgängigen Prozess:

Das System automatisiert die Feature-Erstellung und Modellsuche, generiert nachvollziehbare Notebooks zur Prüfung und Anpassung, führt eine strenge Validierung mit Rolling-Backtests und Kennzahlen wie MAPE oder RMSE durch und erleichtert die Bereitstellung über MLflow und Unity Catalog.

Im gezeigten Beispiel liefert dieser End-to-End-Workflow nicht nur ein präzises Modell, sondern bildet auch saisonale Muster – wie Umsatzspitzen, Nachfragetäler und anschließende Erholungsphasen – realitätsnah ab.

Wer also schnelle, verlässliche und erklärbare Umsatzprognosen benötigt, findet in AutoML auf der Lakehouse-Plattform eine leistungsfähige Standardlösung.

Haben Sie Fragen zu diesem oder anderen Themen? Wir freuen wir uns darauf, mehr über Ihre Herausforderungen zu erfahren und helfen Ihnen gerne dabei, optimale Lösungen zu finden und diese umzusetzen.

FAQ - Databricks AutoML

Hier finden Sie einige der häufig gestellten Fragen zur Databricks AutoML.

Data Science & Engineering, Databricks

/Logo%202023%20final%20dunkelgrau.png?width=221&height=97&name=Logo%202023%20final%20dunkelgrau.png)